热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

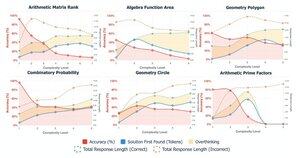

📢 LLM真的能在数学上跳出框框思考吗?还是说它们只是重新组合熟悉的策略?

记得DeepSeek R1,o1在奥林匹克级别的数学上给我们留下了深刻印象,但它们在简单的算术上却也失败了😬

我们建立了一个基准来找出答案→OMEGA Ω 📐

💥 我们发现,尽管非常强大,RL在组合技能和创新未在训练中见过的新策略方面仍然存在困难。👇

与@UCBerkeley @allen_ai合作

关于我们所学到的内容的讨论🧵

🤯 我们注意到,许多失败并非源于知识的缺乏,而是由于过度思考。模型通常在链式推理的早期找到正确答案,但却陷入自我修正,放弃了正确的解决方案。这挑战了一个假设:

更多的链式推理 ≠ 更好的结果

有时,模型的自我修正机制可能会无意中适得其反。

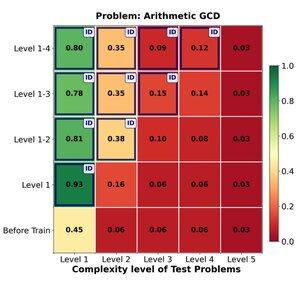

🔁 强化学习能否有效地从简单问题推广到困难问题?我们发现早期有显著的提升,但随着任务复杂度的增加,推广效果趋于平稳。

在1-4级的训练对领域内问题提供了很大的提升,例如在1级(📈 0.45 → 0.80经过强化学习)。

但是当我们增加难度时,

📉 在同一问题家族上的表现下降。

⚠️ 学习到的策略有其伸展的极限。

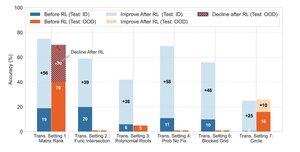

🧠 变革性概括?

仍然遥不可及。当成功依赖于发明新的解决策略(例如,巧妙的对称而不是蛮力)时,模型即使在强化学习(RL)之后也会持续失败。

强化学习可以显著提高在训练期间观察到的熟悉模式下的任务表现,但当成功依赖于创造性洞察或未在数据中明确展示的推理策略时,它却显得力不从心。

170.12K

热门

排行

收藏