トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

📢 LLMは本当に数学の枠外で推論できますか?それとも、おなじみの戦略をリミックスしているだけなのでしょうか?

DeepSeek R1、o1は、オリンピアードレベルの数学で私たちに感銘を与えましたが、単純な算術😬でも失敗していたことを思い出してください

OMEGA Ω→を見つけるためのベンチマークを構築しました 📐

💥 RLは非常に強力ですが、スキルを構成したり、トレーニング中には見られなかった新しい戦略を革新したりするのに苦労していることがわかりました。👇

@UCBerkeley @allen_aiの仕事

私たちが学んだ🧵ことのスレッド

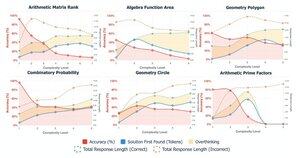

🤯 私たちは、多くの失敗が知識の欠如ではなく、考えすぎから生じていることに気づきました。モデルは、CoTの早い段階で正しい答えを見つけることがよくありますが、自己修正に陥り、正しい解決策を放棄します。これは、仮定に異議を唱えます。

CoTが多ければ多いほど≠より良い結果が得られます

モデルの自己修正メカニズムが誤って裏目に出ることがあります

🔁 RLは簡単な問題から難しい問題まで効果的に一般化できるか?初期の段階では大きな利益が得られますが、一般化はタスクの複雑さとともに停滞します

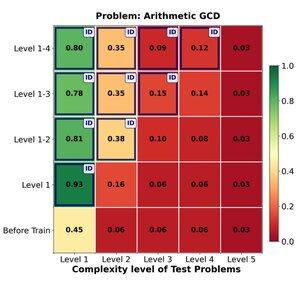

レベル1〜4のトレーニングは、レベル1(📈 RL後0.45→0.80)などのドメイン内の問題を確実に後押しします。

しかし、難易度を上げると

📉 同じ問題ファミリでパフォーマンスが低下します。

⚠️ 学習した戦略をどこまで伸ばすことができるかには限界があります

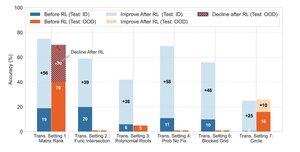

🧠 変革的な一般化?

まだ手の届かないところにあります。成功が新しいソリューション戦略の発明にかかっている場合 (たとえば、力ずくではなく巧妙な対称性)、RL の後でもモデルは一貫して失敗します。

RLは、トレーニング中に観察されたおなじみのパターンに従うタスクのパフォーマンスを大幅に向上させることができますが、データで明示的に示されていない創造的な洞察や推論戦略に成功が依存する場合は苦労します。

170.11K

トップ

ランキング

お気に入り