Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

📢 Чи справді LLM можуть міркувати нестандартно в математиці? Чи вони просто реміксують знайомі стратегії?

Пам'ятайте, що DeepSeek R1, o1 вразили нас математикою олімпіадного рівня, але також вони зазнали невдачі в простій арифметиці 😬

Ми створили бенчмарк, щоб дізнатися → OMEGA Ω 📐

💥 Ми виявили, що, незважаючи на те, що RL дуже потужний, йому важко компонувати навички та впроваджувати нові стратегії, які не були помічені під час тренувань. 👇

Робота з @UCBerkeley @allen_ai

Тред про те, що ми дізналися 🧵

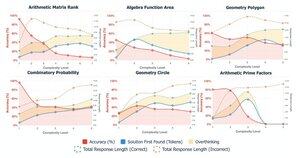

🤯 Ми помітили, що багато невдач виникають не через брак знань, а через надмірне обмірковування. Моделі часто знаходять правильну відповідь на ранніх стадіях CoT, але впадають у самокорекцію і відмовляються від правильних рішень. Це ставить під сумнів припущення:

Більше CoT ≠ кращі результати

Іноді механізми самокорекції моделей можуть ненавмисно дати зворотний ефект

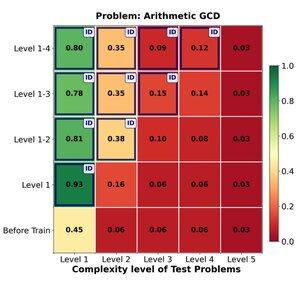

🔁 Чи може РЛ ефективно узагальнювати від легких до складних задач? Ми знаходимо сильні ранні здобутки, але узагальнення виходить на плато зі складністю завдання

Тренування на 1–4 рівнях дає значний поштовх до вирішення проблем у домені, наприклад, на рівні 1 (📈 0,45 → 0,80 після RL).

АЛЕ коли ми збільшуємо складність

📉 Продуктивність падає на тому ж сімействі проблем.

⚠️ Існують межі того, як далеко можуть простягатися вивчені стратегії

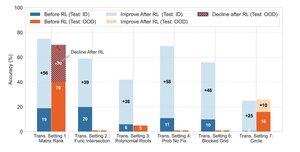

🧠 Трансформаційне узагальнення?

Все ще поза зоною досяжності. коли успіх залежить від винаходу нової стратегії рішення (наприклад, розумна симетрія замість грубої сили), моделі постійно зазнають невдачі навіть після RL.

РЛ може значно підвищити продуктивність при виконанні завдань, які слідують знайомим моделям, що спостерігаються під час тренування, він відчуває труднощі, коли успіх залежить від творчого розуміння або стратегій міркування, явно не продемонстрованих у даних.

170,11K

Найкращі

Рейтинг

Вибране