Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

📢 Kunnen LLM's echt buiten de gebaande paden redeneren in wiskunde? Of remixen ze gewoon bekende strategieën?

Vergeet DeepSeek R1 niet, o1 heeft ons onder de indruk gebracht met wiskunde op Olympiad-niveau, maar ze faalden ook bij eenvoudige rekenkunde 😬

We hebben een benchmark gebouwd om erachter te komen → OMEGA Ω 📐

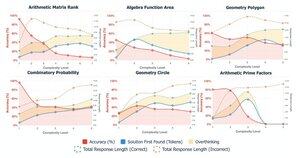

💥 We hebben ontdekt dat, hoewel zeer krachtig, RL moeite heeft om vaardigheden samen te stellen en nieuwe strategieën te innoveren die niet tijdens de training zijn gezien. 👇

werk samen met @UCBerkeley @allen_ai

Een draad over wat we hebben geleerd 🧵

🤯 We hebben opgemerkt dat veel mislukkingen niet voortkomen uit een gebrek aan kennis, maar uit overdenken. Modellen vinden vaak vroeg in CoT het juiste antwoord, maar spiralen in zelfcorrecties en verlaten correcte oplossingen. Dit daagt de veronderstelling uit:

Meer CoT ≠ betere resultaten

Soms kunnen de zelfcorrectiemechanismen van de modellen onbedoeld averechts werken.

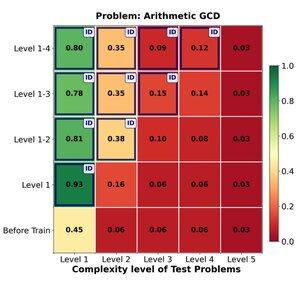

🔁 Kan RL effectief generaliseren van gemakkelijke naar moeilijke problemen? We vinden sterke vroege winsten, maar de generalisatie plateau's met de complexiteit van de taak.

Training op niveaus 1–4 geeft een solide boost op in-domain problemen, bijvoorbeeld op niveau 1 (📈 0.45 → 0.80 na RL).

MAAR wanneer we de moeilijkheid verhogen

📉 daalt de prestatie op dezelfde probleemfamilie.

⚠️ Er zijn grenzen aan hoe ver geleerde strategieën kunnen reiken.

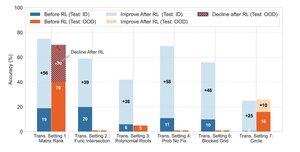

🧠 Transformative generalisatie?

Nog steeds buiten bereik. Wanneer succes afhangt van het uitvinden van een nieuwe oplossingsstrategie (bijv. slimme symmetrie in plaats van brute kracht), falen modellen consequent, zelfs na RL.

RL kan de prestaties op taken die volgen op bekende patronen die tijdens de training zijn waargenomen, aanzienlijk verbeteren, maar het heeft moeite wanneer succes afhangt van creatieve inzichten of redeneervaardigheden die niet expliciet in de gegevens zijn aangetoond.

170,18K

Boven

Positie

Favorieten