Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

📢 Can LLMs really reason outside the box in math? Or are they just remixing familiar strategies?

Remember DeepSeek R1, o1 have impressed us on Olympiad-level math but also they were failing at simple arithmetic 😬

We built a benchmark to find out → OMEGA Ω 📐

💥 We found that although very powerful, RL struggles to compose skills and to innovate new strategies that were not seen during training. 👇

work w. @UCBerkeley @allen_ai

A thread on what we learned 🧵

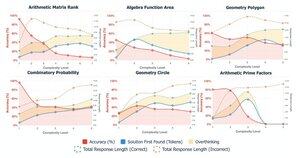

🤯 Abbiamo notato che molti fallimenti non derivano dalla mancanza di conoscenza, ma dal pensare troppo. I modelli spesso trovano la risposta giusta all'inizio del CoT, ma si perdono in autocorrezioni e abbandonano soluzioni corrette. Questo mette in discussione l'assunzione:

Più CoT ≠ risultati migliori

A volte i meccanismi di autocorrezione dei modelli possono inavvertitamente ritorcersi contro.

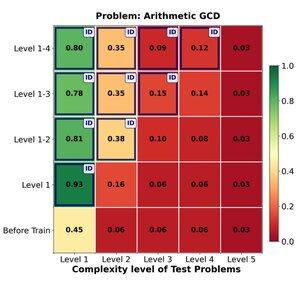

🔁 Può l'RL generalizzare efficacemente da problemi facili a problemi difficili? Troviamo forti guadagni iniziali, ma la generalizzazione si stabilizza con la complessità del compito.

L'addestramento sui livelli 1–4 offre un buon impulso sui problemi in dominio, ad esempio, al livello 1 (📈 0.45 → 0.80 dopo l'RL).

MA quando aumentiamo la difficoltà

📉 le prestazioni calano sulla stessa famiglia di problemi.

⚠️ Ci sono limiti a quanto possono estendersi le strategie apprese.

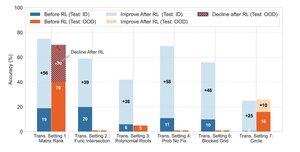

🧠 Generalizzazione trasformativa?

Ancora fuori portata. Quando il successo dipende dall'invenzione di una nuova strategia di soluzione (ad esempio, simmetria ingegnosa invece di forza bruta), i modelli falliscono costantemente anche dopo l'apprendimento per rinforzo.

L'apprendimento per rinforzo può migliorare sostanzialmente le prestazioni in compiti che seguono schemi familiari osservati durante l'addestramento, ma fatica quando il successo dipende da intuizioni creative o strategie di ragionamento non esplicitamente dimostrate nei dati.

170,12K

Principali

Ranking

Preferiti