Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

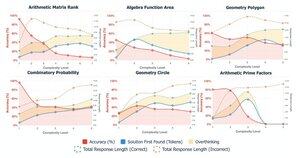

📢 Can LLMs really reason outside the box in math? Or are they just remixing familiar strategies?

Remember DeepSeek R1, o1 have impressed us on Olympiad-level math but also they were failing at simple arithmetic 😬

We built a benchmark to find out → OMEGA Ω 📐

💥 We found that although very powerful, RL struggles to compose skills and to innovate new strategies that were not seen during training. 👇

work w. @UCBerkeley @allen_ai

A thread on what we learned 🧵

🤯 Vi la merke til at mange feil ikke stammer fra mangel på kunnskap, men fra overtenking. Modeller finner ofte det riktige svaret tidlig i CoT, men spiraler inn i selvkorreksjoner og forlater riktige løsninger. Dette utfordrer antakelsen:

Mer CoT ≠ bedre resultater

Noen ganger kan modellenes selvkorreksjonsmekanismer utilsiktet slå tilbake

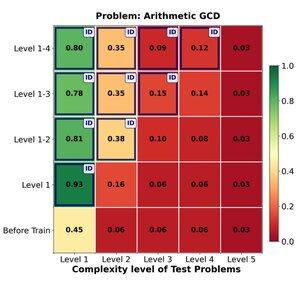

🔁 Kan RL effektivt generalisere fra enkle til vanskelige problemer? Vi finner sterke tidlige gevinster, men generaliseringsplatåer med oppgavekompleksitet

Trening på nivå 1–4 gir et solid løft på in-domain problemer, for eksempel på nivå 1 (📈 0,45 → 0,80 etter RL).

MEN når vi øker vanskelighetsgraden

📉 ytelsen faller på samme problemfamilie.

⚠️ Det er grenser for hvor langt lærte strategier kan strekke seg

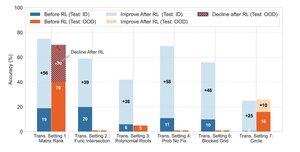

🧠 Transformativ generalisering?

Fortsatt utenfor rekkevidde. når suksess avhenger av å finne opp en ny løsningsstrategi (f.eks. smart symmetri i stedet for brute force), mislykkes modeller konsekvent selv etter RL.

RL kan forbedre ytelsen betydelig på oppgaver som følger kjente mønstre observert under trening, den sliter når suksess avhenger av kreativ innsikt eller resonnementstrategier som ikke eksplisitt er demonstrert i dataene.

170,12K

Topp

Rangering

Favoritter