Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

📢 Os LLMs podem realmente raciocinar fora da caixa em matemática? Ou eles estão apenas remixando estratégias familiares?

Lembre-se de que o DeepSeek R1, o1 nos impressionou em matemática de nível olímpico, mas também estava falhando em aritmética 😬 simples

Construímos um benchmark para descobrir → a OMEGA Ω 📐

💥 Descobrimos que, embora muito poderoso, o RL luta para compor habilidades e inovar novas estratégias que não foram vistas durante o treinamento. 👇

trabalho w. @UCBerkeley @allen_ai

Um tópico sobre o que aprendemos 🧵

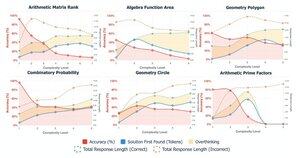

🤯 Percebemos que muitos fracassos não decorrem da falta de conhecimento, mas do excesso de pensamento. Os modelos geralmente encontram a resposta certa no início do CoT, mas entram em autocorreções e abandonam as soluções corretas. Isso desafia a suposição:

Mais CoT ≠ melhores resultados

Às vezes, os mecanismos de autocorreção dos modelos podem inadvertidamente sair pela culatra

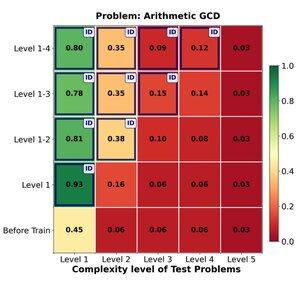

🔁 A RL pode efetivamente generalizar de problemas fáceis para difíceis? Encontramos fortes ganhos iniciais, mas a generalização se estabiliza com a complexidade da tarefa

O treinamento nos níveis 1–4 dá um impulso sólido em problemas de domínio, por exemplo, no nível 1 (📈 0,45 → 0,80 após RL).

MAS quando aumentamos a dificuldade

📉 o desempenho cai na mesma família de problemas.

⚠️ Existem limites para o quão longe as estratégias aprendidas podem se estender

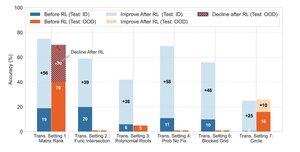

🧠 Generalização transformadora?

Ainda fora de alcance. quando o sucesso depende da invenção de uma nova estratégia de solução (por exemplo, simetria inteligente em vez de força bruta), os modelos falham consistentemente mesmo após RL.

A RL pode melhorar substancialmente o desempenho em tarefas que seguem padrões familiares observados durante o treinamento, ela luta quando o sucesso depende de insights criativos ou estratégias de raciocínio não explicitamente demonstradas nos dados.

170,19K

Melhores

Classificação

Favoritos