Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

📢 Mohou LLM skutečně uvažovat mimo rámec v matematice? Nebo jen remixují známé strategie?

Vzpomeňte si na DeepSeek R1, o1 na nás zapůsobili v matematice na úrovni olympiády, ale také selhávali v jednoduché aritmetice 😬

Vytvořili jsme benchmark, abychom zjistili, → OMEGA Ω 📐

💥 Zjistili jsme, že i když je RL velmi silný, má potíže se skládáním dovedností a inovacemi nových strategií, které nebyly během tréninku k vidění. 👇

práce s @UCBerkeley @allen_ai

Vlákno o tom, co jsme se naučili 🧵

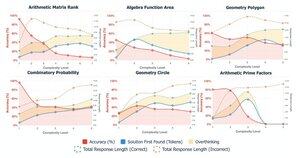

🤯 Všimli jsme si, že mnoho neúspěchů nepramení z nedostatku znalostí, ale z přílišného přemýšlení. Modely často najdou správnou odpověď na začátku CoT, ale sklouznou do spirály sebekorekcí a opouštějí správná řešení. To zpochybňuje předpoklad:

Více CoT ≠ lepší výsledky

Někdy se mohou samoopravné mechanismy modelů neúmyslně obrátit proti nim

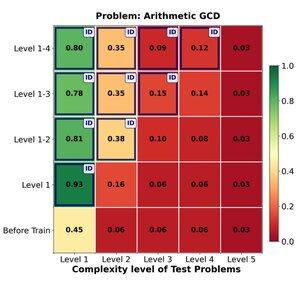

🔁 Dokáže RL efektivně zobecnit od jednoduchých k obtížným problémům? Zjistili jsme silné počáteční zisky, ale zobecnění stagnuje se složitostí úkolu

Trénink na úrovních 1–4 poskytuje solidní podporu při řešení problémů v oblasti, např. na úrovni 1 (📈 0,45 → 0,80 po RL).

ALE když zvýšíme obtížnost

📉 klesá výkon u stejné skupiny problémů.

⚠️ Existují limity, jak daleko mohou naučené strategie sahat

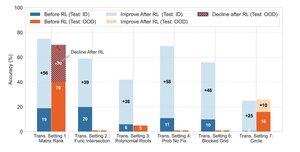

🧠 Transformativní zobecnění?

Stále mimo dosah. když úspěch závisí na vynalezení nové strategie řešení (např. chytrá symetrie místo hrubé síly), modely konzistentně selhávají i po RL.

RL může podstatně zvýšit výkon při úkolech, které se řídí známými vzorci pozorovanými během tréninku, má problémy, když úspěch závisí na kreativním vhledu nebo strategiích uvažování, které nejsou v datech explicitně demonstrovány.

170,11K

Top

Hodnocení

Oblíbené