Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

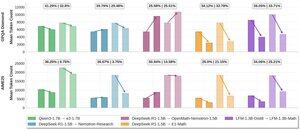

Glad for å dele innsikt i vårt arbeid med effektiv resonnering @LiquidAI_:

Vi gjør en 1.3B generell chat-modell til en sterk matematisk resonnement som forblir kortfattet. SFT på kuraterte CoT-sporinger låser opp sterke resonnementer og målrettet RL-kontrollerer ordlyd.

Oppskriften er enkel og gir et interessant datapunkt for ikke-Qwen-baserte modeller. Dette er fortsatt basert på vår første generasjon LFM-er - spent på neste generasjon!

Vennligst finn detaljer i vårt blogginnlegg!

@LiquidAI_

4,14K

Topp

Rangering

Favoritter