Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

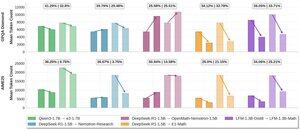

S radostí se s vámi podělíme o poznatky o naší práci na efektivních @LiquidAI_ uvažování:

Změníme obecný model chatu o velikosti 1,3 B na silný matematický argument, který zůstává stručný. SFT na kurátorských trasách CoT odemyká silné uvažování a cílené RL kontroluje mnohomluvnost.

Recept je jednoduchý a poskytuje zajímavý datový bod pro modely, které nejsou založeny na Qwen. To je stále založeno na naší první generaci LFM - nadšeni z další generace!

Podrobnosti najdete v našem příspěvku na blogu!

@LiquidAI_

4,15K

Top

Hodnocení

Oblíbené