Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

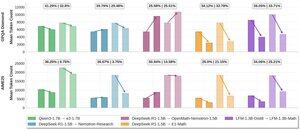

Ich freue mich, Einblicke in unsere Arbeit an effizientem Denken @LiquidAI_ zu teilen:

Wir verwandeln ein 1,3B allgemeines Chat-Modell in einen starken mathematischen Denker, der prägnant bleibt. SFT auf kuratierten CoT-Spuren ermöglicht starkes Denken und gezielte RL-Kontrollen der Wortanzahl.

Das Rezept ist einfach und bietet einen interessanten Datenpunkt für nicht-Qwen-basierte Modelle. Dies basiert immer noch auf unserer ersten Generation von LFMs - ich bin gespannt auf die nächste Generation!

Bitte finden Sie die Details in unserem Blog-Beitrag!

@LiquidAI_

4,18K

Top

Ranking

Favoriten