Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Ramez Naam

Инвестор в климат и чистую энергетику. Автор 5 книг. Сопредседатель @SingularityU по вопросам энергетики и окружающей среды. Пытаемся построить лучший мир.

Торий не является панацеей для ядерной энергетики.

Nick Touran9 часов назад

Торий — это отличный ядерный топливо, но в нем нет ничего магического. Люди в интернете почти всегда ошибочно сравнивают урановые неразмножители с размножителями тория и приходят к выводу, что Торий выигрывает, забывая упомянуть, что уран тоже может размножаться. Вот печально известные мифы о тории... 🧵

1,13K

Это, действительно, одно из применений ИИ, которое меня больше всего беспокоит. Социальные сети уже сломали политику США. ИИ вполне может сломать её ещё больше.

David22 часа назад

Честно говоря, я напуган мощью и масштабами технологий ИИ, которые будут использованы на предстоящих президентских выборах 2028 года. Это может стать поворотным моментом для цивилизации. Мы не готовы. Нам, вероятно, стоит начать подготовку или хотя бы обсудить, как мы могли бы подготовиться.

1,77K

Ramez Naam сделал репост

Мне нравятся эти идеи от руководителя компании Schneider Electric (ключевого игрока в строительстве дата-центров).

"

Аппаратное обеспечение ИИ переписывает энергетический баланс дата-центров. Один стойка NVIDIA Blackwell 2 теперь потребляет примерно 180-200 кВт, увеличивая общие потребности сайта с ~300 МВт до 1.2-1.5 ГВт — увеличение в 4-5 раз за один архитектурный цикл.

Энергетические всплески (“300 МВт → 1.5 ГВт → 500 МВт”) нагружают трансформаторы и распределительные активы, которые были построены 30-50 лет назад и никогда не были предназначены для такой волатильности, заставляя коммунальные службы и операторов пересмотреть стратегии укрепления сети и генерации на месте.

Задержка, а не земля, определяет географию — отсюда и рост “метро микро-дата-центров.” Гипермасштабные компании все еще предпочитают пустынные “мега” площадки, но рабочие нагрузки в реальном времени (торговля, контроль качества высокоскоростного производства, роботизированная сборка) не могут терпеть обратный путь к удаленным супер-кластерам.

Результат: площади дата-центров возвращаются в густонаселенные регионы (например, AI Hub в Пенсильвании) и даже на заводские полы, где комнаты edge или “микро-облака” размещают смешанные стойки устаревших ПЛК, процессоров Xeon/EPYC и высококлассных GPU, чтобы поддерживать вывод внутри диапазона 20-50 мс.

Ядерное “мини-возрождение” финансируется облачными гигантами. Microsoft уже подписала 20-летний контракт на возобновление работы блока 1 на острове Три Мили; поставщики малых модульных реакторов (GE, Westinghouse, Rolls-Royce) позиционируют небольшие реакторы как базовую нагрузку для гипермасштабных кампусов.

Операторы признают, что инженерный и регуляторный путь нов и требует больших капиталовложений, но рассматривают ядерную энергетику как единственный углеродно-нейтральный источник, который работает 24×7 и масштабируется с ростом спроса на ИИ.

Охлаждение и вспомогательные системы на месте — следующая горячая точка для инвестиций. Традиционное однофазное охлаждение уже недостаточно; многопоточные жидкостные системы становятся обязательными для тепловых нагрузок класса Blackwell.

Операторы оценивают возможность использования дизельных или газовых генераторов — и в конечном итоге малых модульных реакторов — для локального обеспечения “коммунальных нагрузок” (охлаждение, вентиляция, безопасность), сокращая потребление сети примерно на 40% и облегчая узкие места в подключении. Эти ниши создают новый цикл капитальных затрат для производителей систем теплового управления и поставщиков распределенной генерации.

Паузы не предвидится — дорожные карты чипов и волатильность программного обеспечения продолжают ускорять капитальные затраты.

С каждым поколением GPU, обеспечивающим более высокую плотность, дата-центры требуют постоянных электрических и механических модернизаций; гипермасштабные компании смешивают собственные площадки с постоянной нагрузкой и всплесковой мощностью от Tier-1 колокаций (Equinix, NTT, Compass и др.).

Спрос на программное обеспечение еще менее предсказуем: новые китайские LLM (DeepSeek, Alibaba, Tencent) и все еще неизвестные академические прорывы могут еще больше увеличить вычислительную интенсивность, делая любые прогнозы на два-пять лет крайне неопределенными. Инвесторам следует одновременно отслеживать четыре направления — академические, стартапы, гипермасштабные компании и тенденции распределения капитала — чтобы избежать слепых зон.

"

59,77K

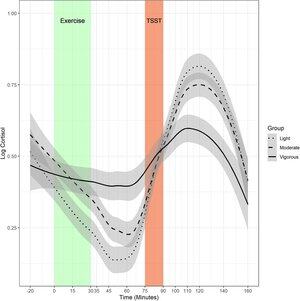

Отлично видеть. Работа @tylerhnorris показала, что если дата-центры ИИ смогут немного гибче подходить к своим требованиям по мощности, мы могли бы добавить десятки ГВт вычислительных мощностей без нового поколения. Здорово, что Google берет на себя инициативу в реализации этого.

Shanu Mathew4 авг., 22:24

Сказал вам, что это было лишь вопросом времени. При равных условиях, конечно, не имеет смысла быть гибким. Но если это станет необходимым для решения проблемы с временем генерации энергии, технологические гиганты проявят креативность.

Google: "Перейдем к сегодняшнему дню, мы разработали новые возможности для переноса вычислительных задач - и, что особенно важно, задач машинного обучения - чтобы помочь удовлетворить растущие энергетические потребности мира, минимизируя время и затраты, необходимые для добавления нового поколения в систему."

cc: @tylerhnorris (спасибо за находку) @ramez @azeem @JesseJenkins @JessePeltan

10,77K

Ramez Naam сделал репост

Нельзя построить государство на фантазиях.

Ядерная энергия: 10–15 лет до реализации

Уголь: Никаких новых проектов не запланировано

Газ: Задержки на 5–7 лет

Штаты, запрещающие солнечную и ветровую энергетику, выбирают проигравших — и гарантируют провал.

Когда газ поймет, что он — *единственный* ресурс, который государство разрешит, цены взлетят.

32,48K

Прошлое было ужасным и чертовски невежественным.

Alec Stapp2 авг., 18:12

Ученый, который обнаружил, что мытье рук значительно снижает смертность во время родов, был высмеян своими коллегами и помещен в психиатрическую больницу.

В больнице его избивали охранники, и он умер через 2 недели после того, как рана на его руке стала гангренозной.

8,97K

Ramez Naam сделал репост

Статья "Иерархические модели рассуждений" в последнее время активно обсуждается, собирая десятки тысяч лайков в Twitter на десятках полувирусных тем, что довольно необычно для научной работы.

В статье утверждается, что точность составляет 40,3% на ARC-AGI-1 с маленькой моделью (27M параметров), обученной с нуля без каких-либо внешних данных для обучения — если это правда, это будет представлять собой значительный прорыв в области рассуждений.

Я только что подробно изучил статью и кодовую базу...

Это хорошее чтение, детализированное, но легкое для понимания. Я думаю, что представленные идеи довольно интересны, и архитектура, вероятно, ценна.

Концепция напоминает мне множество различных идей, с которыми я столкнулся в "золотую эпоху" исследований архитектуры глубокого обучения, примерно с 2016 по 2018 год. Этот тип исследований не был популярен в течение некоторого времени, поэтому приятно видеть возобновленный интерес к альтернативным архитектурам.

Тем не менее, экспериментальная установка, похоже, критически ошибочна, что означает, что у нас в настоящее время нет эмпирического сигнала (по крайней мере, от ARC-AGI) о том, действительно ли архитектура полезна или нет.

Эксперимент ARC-AGI-1 делает следующее, основываясь на моем анализе кода подготовки данных:

1. Обучение на 876,404 задачах, которые являются вариантами 960 оригинальных задач, сгенерированных с помощью аугментации:

... 400 из ARC-AGI-1/train

... 400 из ARC-AGI-1/eval

... 160 из ConceptARC

2. Тестирование на 400 задачах (ARC-AGI-1/eval), путем аугментации каждой задачи в ~1000 вариантов (на самом деле всего 368,151 из-за особенностей процесса аугментации), производя предсказание для каждого варианта и сокращая предсказания до N=2 с помощью голосования большинства.

Короче говоря: они обучаются на тестовых данных.

Вы можете спросить, подождите, почему тогда точность 40%, а не 100%? Модель сильно недообучена?

Это потому, что обучающие данные и тестовые данные представляют собой одни и те же оригинальные задачи *в разных вариациях*. Аугментация данных применяется независимо к задачам eval в обучающих данных и задачам eval в тестовых данных.

Таким образом, то, что измеряет эксперимент, в общем, это то, как модель справляется с обобщением на процедурно сгенерированные варианты одних и тех же задач (т.е. может ли модель научиться обратным преобразованиям фиксированного набора статических сеточных трансформаций).

Так что — не стоит слишком радоваться пока. Но я действительно думаю, что такие исследования архитектуры ценны (когда они сопровождаются надлежащим эмпирическим сигналом валидации) и что идея HRM очень интересна.

Также, чтобы было ясно, я не думаю, что авторы имели намерение ввести в заблуждение и скрыть экспериментальную проблему — они, вероятно, не осознавали, что на самом деле означает их установка для обучения.

19,59K

Топ

Рейтинг

Избранное

В тренде ончейн

В тренде в Х

Самые инвестируемые

Наиболее известные