Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Chi ha inventato le reti neurali convoluzionali (CNN)?

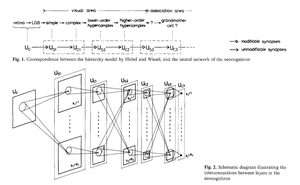

1969: Fukushima aveva ReLU rilevanti per le CNN [2].

1979: Fukushima aveva l'architettura di base delle CNN con strati di convoluzione e strati di downsampling [1]. Il calcolo era 100 volte più costoso rispetto al 1989 e un miliardo di volte più costoso rispetto a oggi.

1987: Waibel applicò il backpropagation di Linnainmaa del 1970 [3] a TDNN con condivisione dei pesi e convoluzioni unidimensionali [4].

1988: Wei Zhang et al. applicarono CNN bidimensionali "moderne" addestrate con backpropagation al riconoscimento dei caratteri [5].

Tutto quanto sopra è stato pubblicato in Giappone dal 1979 al 1988.

1989: LeCun et al. applicarono nuovamente le CNN al riconoscimento dei caratteri (codici postali) [6,10].

1990-93: Il downsampling di Fukushima basato su media spaziale [1] fu sostituito dal max-pooling per TDNN unidimensionali (Yamaguchi et al.) [7] e CNN bidimensionali (Weng et al.) [8].

2011: Molto più tardi, il mio team con Dan Ciresan rese le CNN con max-pooling davvero veloci su GPU NVIDIA. Nel 2011, DanNet raggiunse il primo risultato di riconoscimento di pattern sovrumano [9]. Per un po', godette di un monopolio: da maggio 2011 a settembre 2012, DanNet vinse ogni sfida di riconoscimento delle immagini a cui partecipò, 4 di esse di seguito. Ammettiamo, tuttavia, che questo riguardava principalmente l'ingegneria e l'ampliamento delle intuizioni di base del millennio precedente, beneficiando di hardware molto più veloce.

Alcuni "esperti di IA" affermano che "far funzionare le CNN" (ad es., [5,6,9]) fosse importante quanto inventarle. Ma "farle funzionare" dipendeva in gran parte dal fatto che il tuo laboratorio fosse abbastanza ricco da acquistare i computer più recenti necessari per ampliare il lavoro originale. È lo stesso di oggi. Ricerca di base contro ingegneria/sviluppo - la R contro la D in R&D.

RIFERIMENTI

[1] K. Fukushima (1979). Modello di rete neurale per un meccanismo di riconoscimento dei pattern non influenzato dallo spostamento di posizione — Neocognitron. Trans. IECE, vol. J62-A, n. 10, pp. 658-665, 1979.

[2] K. Fukushima (1969). Estrazione di caratteristiche visive tramite una rete multilivello di elementi soglia analogici. IEEE Transactions on Systems Science and Cybernetics. 5 (4): 322-333. Questo lavoro ha introdotto le unità lineari rettificate (ReLU), ora utilizzate in molte CNN.

[3] S. Linnainmaa (1970). Tesi di laurea, Univ. Helsinki, 1970. La prima pubblicazione sul "moderno" backpropagation, noto anche come modalità inversa della differenziazione automatica. (Vedi la nota panoramica sul backpropagation di Schmidhuber: "Chi ha inventato il backpropagation?")

[4] A. Waibel. Riconoscimento dei fonemi utilizzando reti neurali a ritardo temporale. Incontro dell'IEICE, Tokyo, Giappone, 1987. Backpropagation per un TDNN con condivisione dei pesi con convoluzioni unidimensionali.

...

Principali

Ranking

Preferiti