Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

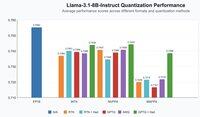

Annunciamo il nostro primo lavoro sull'inferenza FP4 per gli LLM!

- QuTLASS: supporto del kernel a bassa precisione per le GPU Blackwell

- FP-Quant: un cablaggio di quantizzazione flessibile per Llama/Qwen

Raggiungiamo un'accelerazione 4x rispetto a BF16, con una buona precisione grazie al microscaling MXFP4 + rotazioni Hadamard fuse.

22,56K

Principali

Ranking

Preferiti