Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Vždy je příjemné vidět více práce na rozšíření diloka a snížení požadavků na šířku pásma pro předtrénink!

22. 8. 2025

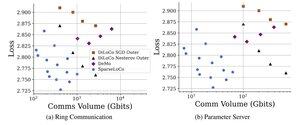

Introducing SparseLoCo: a communication-efficient method for LLM pre-training.

TL;DR: We leverage Top-k sparsification + error feedback with DiLoCo’s infrequent outer steps—communicating only 1–3% gradients with 2-bit quantization—outperforming DiLoCo and DeMo. 1/N,

ArXiv:

Github:

4,95K

Top

Hodnocení

Oblíbené