Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

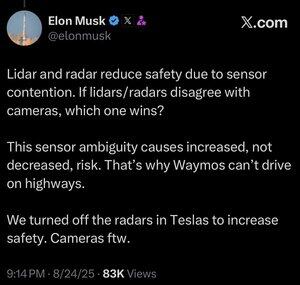

Más datos no siempre es mejor.

Cuando un sistema automatizado tiene que tomar una decisión rápidamente, desea que tenga el conjunto más reducido posible de datos relevantes necesarios para tomar la decisión correcta.

Analizar más cosas solo te hace más lento.

Puedes ver esto en los humanos. El campo de la inteligencia artificial siempre está copiando la tarea de la evolución, y por una buena razón. ¿Por qué tirar por la borda todos esos millones de años de resultados emergentes y tratar de empezar de nuevo desde cero?

Los humanos en realidad no tienen cinco sentidos (más bien unos 22), pero una cosa que no vemos mucho en esos sentidos es la superposición.

Parece que el proceso evolutivo ha dado con la noción, una y otra vez, de que es mejor afinar los globos oculares para lo que necesita ver, en lugar de desarrollar dos o tres tipos diferentes de globos oculares para mirar lo mismo.

Claro, los enfoques multicanal no son imposibles, y tal vez se podría hacer que funcione un sistema solo de lidar.

Pero lo que pasa con el uso de cámaras que son análogas a la visión humana, es que puedes copiar todo lo que sabemos sobre la visión humana.

Y si estás usando eso para conducir automóviles, entonces obtienes cuna de todo lo que sabemos o podemos descubrir sobre cómo los humanos conducen automóviles.

Si eres algún tipo de ingeniero, esto es una obviedad y, a pesar de lo que Lexxie pueda pensar, o fingir pensar mientras las cámaras están rodando, Elon Musk es todo ingeniero, 100% ingeniero y muy poco más, y cualquier otro ingeniero puede detectar esto solo por cómo habla.

Lidar es bueno para muchas cosas, probablemente incluyendo naves espaciales, pero cuando lo pones en un coche, es sólo una admisión pública de que no tienes las habilidades, o simplemente no te has molestado, para desarrollar la capacidad de IA para apuntar una cámara a algo y caracterizar realmente lo que estás mirando.

25 ago, 13:59

No estoy seguro de que esto tenga sentido. De acuerdo, Elon es mucho más inteligente que yo, pero aquí están mis 2 centavos:

No creo que la fusión de sensores sea imposible, solo hace que el sistema sea mucho más complicado. Puedo ver un objeto, tocarlo, olerlo, y mi cerebro puede fusionar todo eso de forma natural. No creo que la fusión de sensores sea intrínsecamente menos segura, pero aumenta la complejidad del sistema y aumenta el número de puntos de falla. El principal problema de Tesla era que su radar en el automóvil era de muy baja resolución.

Waymo aún no puede conducir en carreteras con clientes, en parte debido al alcance de los sensores LIDAR y al ajuste de eso para la conducción a alta velocidad. Y por el riesgo adicional de las altas velocidades. Pero en realidad ahora están corriendo en las carreteras sin nadie en el asiento del conductor y dejando que los empleados jueguen con eso. Así que no creo que sea justo decir que no pueden conducir en las autopistas, simplemente no se sienten cómodos dejando que los clientes lo usen todavía.

Mi argumento favorito de por qué el aprendizaje profundo supera a un enfoque multisensor es que el conjunto de datos a gran escala que puede crear con una sola modalidad de sensor de bajo costo es extremadamente poderoso para aumentar la precisión predictiva del modelo. Es posible que tenga todos estos sensores sofisticados, pero si eso significa que su conjunto de datos es una fracción del tamaño, la diversidad, etc., entonces un modelo de solo visión podría superar en precisión predictiva y, por lo tanto, seguridad.

Estoy de acuerdo con él en que solo la visión es mejor, pero no creo que el quid de eso sea la fusión de sensores

21.35K

Populares

Ranking

Favoritas